- Las pruebas con vehículos aéreos no tripulados son cada vez más importantes. Sin embargo, las pruebas con drones suelen consistir en costosas demostraciones en el mundo real o en simulaciones 3D genéricas y limitadas.

- La principal ventaja de esta plataforma es su capacidad para reproducir entornos reales en un entorno virtual, lo que hace que las pruebas con drones sean más realistas, accesibles y escalables.

- Se utilizan dos algoritmos de aprendizaje profundo, YOLO v4 y Mask R-CNN, para crear el entorno de simulación 3D.

Índice

Necesidad actual de entornos de simulación realistas

Con el rápido desarrollo de la tecnología y las aplicaciones de los drones en los últimos años, la demanda de vehículos aéreos no tripulados (UAV) ha aumentado exponencialmente. En consecuencia, los fabricantes de drones han recurrido cada vez más a entornos simulados para probar sus productos, debido a su rentabilidad y seguridad en comparación con las pruebas en el mundo real. Sin embargo, los entornos simulados genéricos y creados manualmente no suelen presentar los retos que se plantean en los escenarios del mundo real.

Entonces, ¿cómo podemos abordar este problema para garantizar que los entornos simulados reflejen con mayor exactitud las condiciones reales? Este fue el reto al que se enfrentaron los investigadores Justin Nakama, Ricky Parada, João P. Matos-Carvalho, Fábio Azevedo, Dário Pedro y Luís Campos. Sus esfuerzos condujeron al desarrollo de un nuevo enfoque basado en algoritmos de aprendizaje automático.

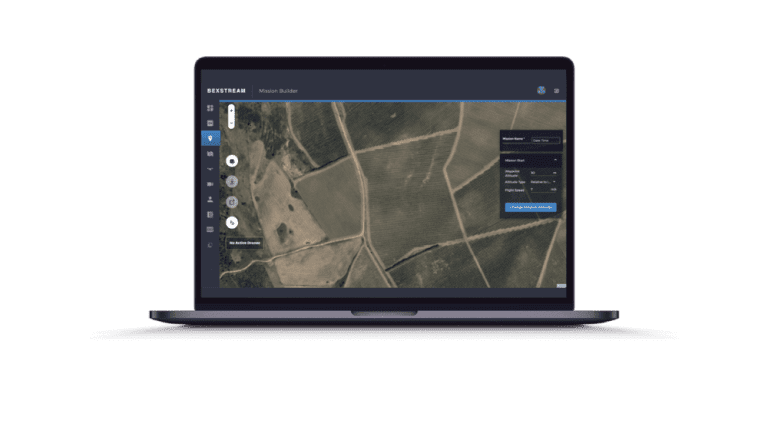

En su artículo, Autonomous Environment Generator for UAV-Based Simulation, proponen un novedoso banco de pruebas en el que el aprendizaje automático se utiliza para generar, escalar y colocar modelos 3D de forma procedimental, lo que da lugar a simulaciones cada vez más realistas. Las imágenes de satélite sirven de base para estos entornos, lo que permite a los usuarios probar vehículos aéreos no tripulados en una representación más detallada de los escenarios del mundo real.

Aunque todavía se necesitan algunas mejoras, su trabajo demuestra una prometedora prueba de concepto para un generador de entornos que puede ahorrar tiempo y recursos en las fases de planificación al proporcionar escenarios virtuales realistas para las pruebas.

Siga leyendo para descubrir más sobre la tecnología que hay detrás de este banco de pruebas disruptivo y sus aplicaciones prácticas.

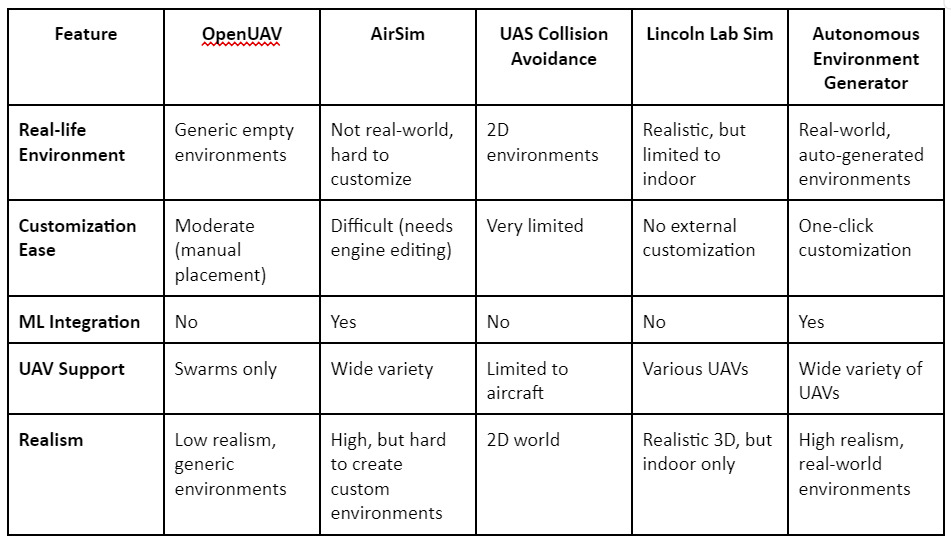

Comparación: Simuladores existentes

Ya existen varias plataformas de bancos de pruebas de UAV, como OpenUAV, AirSim y el simulador de UAV de Lincoln Lab. Aunque estas plataformas ofrecen funciones como pruebas de enjambres de UAV o renderizado de alta calidad, todas se quedan cortas cuando se trata de la generación automática de entornos realistas. Muchas requieren la colocación manual de modelos 3D y no ofrecen la flexibilidad de simular ubicaciones geográficas reales. La plataforma propuesta en este artículo colma estas lagunas automatizando todo el proceso mediante imágenes de satélite, generando así entornos precisos a la carta.

Arquitectura de sistemas y uso de algoritmos de IA

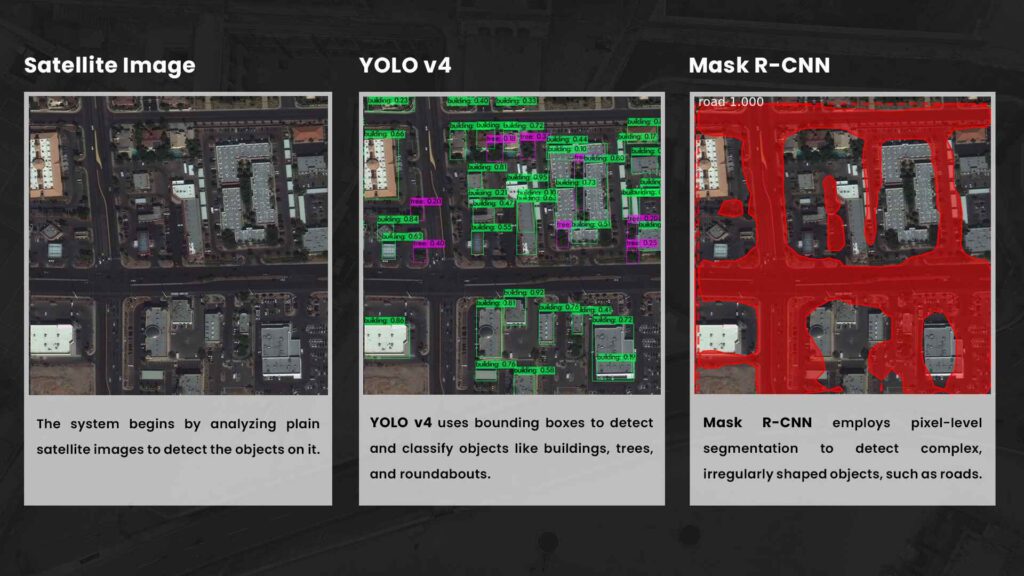

El núcleo del Generador de Entornos Autónomos es una arquitectura que permite representar en el mundo real cualquier zona geográfica. Comienza con imágenes de satélite, que se procesan mediante algoritmos de IA para detectar y reproducir objetos como edificios, árboles y carreteras. A continuación, estos objetos detectados se colocan en la simulación mediante el simulador robótico Gazebo 3D, lo que garantiza que el entorno refleje fielmente el mundo real.

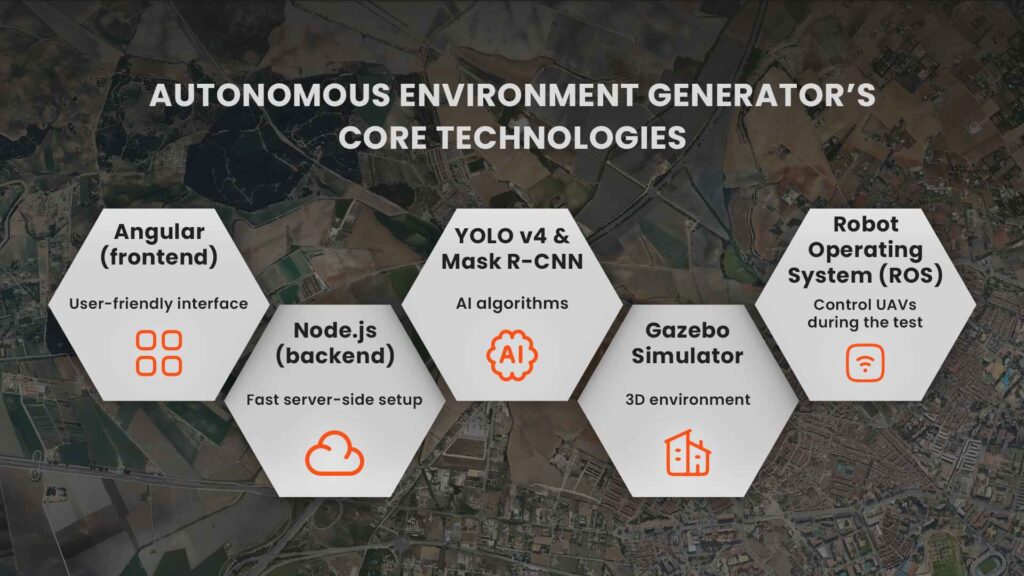

Tecnologías clave del generador de entornos autónomos

La arquitectura del sistema se compone de:

El aprendizaje automático es la fuerza motriz de la capacidad de esta plataforma para crear entornos dinámicos del mundo real. Para crear el entorno de simulación 3D se utilizan dos algoritmos de inteligencia artificial, YOLO v4 y Mask R-CNN.

YOLO v4 es un modelo de detección de objetos de última generación que utiliza redes neuronales convolucionales para identificar y localizar objetos en las imágenes. Funciona dividiendo las imágenes en una cuadrícula y prediciendo la ubicación de los objetos mediante cuadros delimitadores para cada región, lo que permite una detección rápida y precisa. En concreto, YOLO v4 se entrenó con el conjunto de datos DOTA, formado por imágenes aéreas y de satélite, lo que le permitió especializarse en la detección de objetos como edificios, árboles y rotondas a vista de pájaro.

Máscara R-CNNen cambio, se utiliza para la detección de carreteras, que requiere una segmentación a nivel de píxel. Genera máscaras que proporcionan más precisión para formas complejas que no encajan perfectamente en un cuadro delimitador. Este modelo se entrenó utilizando el conjunto de datos Spacenet Road Network Detection Challenge.

Mientras que YOLO v4 es excelente para detectar ciertos objetos, su detección de carreteras es menos precisa, por lo que se incorpora a la arquitectura Mask R-CNN para una segmentación más detallada.

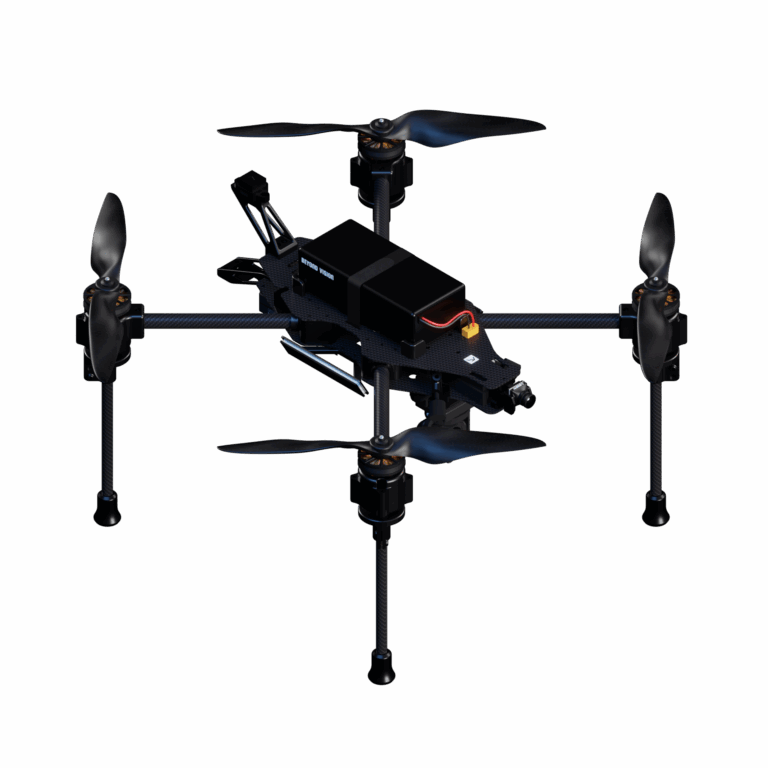

Heifu: el UAV utilizado en las simulaciones

El generador se entrenó con conjuntos de datos de imágenes aéreas y logra un equilibrio entre velocidad y precisión. Una vez procesadas las imágenes de satélite y detectados los objetos, los datos se envían al backend, donde se almacenan para su uso futuro. A continuación, los modelos 3D de edificios, árboles y otros objetos se escalan y se colocan en el simulador Gazebo en sus posiciones geográficas correctas. La simulación se controla mediante el Sistema Operativo de Robots (ROS), que permite a los usuarios controlar manual o autónomamente los vehículos aéreos no tripulados durante la prueba. Los UAV interactúan con estos modelos, lo que permite a los probadores simular escenarios de vuelo reales, como la navegación por un entorno urbano.

Ambos modelos se probaron con diversas imágenes de satélite y, en general, obtuvieron buenos resultados. Sin embargo, siguen existiendo algunos problemas, sobre todo en la colocación de edificios de geometría compleja.

Mientras que YOLO v4 es excelente para detectar ciertos objetos, su detección de carreteras es menos precisa, por lo que se incorpora a la arquitectura Mask R-CNN para una segmentación más detallada.

Aunque el sistema actual carece de algunos detalles gráficos avanzados, la fuerza de la plataforma reside en su escalabilidad y realismo. Elimina la necesidad de entornos de pruebas físicos, lo que hace que las pruebas con UAV sean más baratas, rápidas y accesibles.

¿Qué viene ahora? Mejoras en el generador de entornos autónomos

Aunque el Generador de Entornos Autónomos ya es una herramienta potente, los autores esbozan algunas áreas de mejora para el futuro:

Estas mejoras harán que la plataforma sea aún más versátil y capaz de manejar escenarios de pruebas de UAV más complejos en el futuro.

Un Generador de Entorno Autónomo plantea un futuro prometedor para las pruebas de vehículos aéreos no tripulados y es un sistema que revolucionará la forma en que los fabricantes de drones prueban y garantizan el rendimiento de sus productos.

Generador de entornos autónomos

Una propuesta de sistema que crea automáticamente entornos 3D para pruebas de vehículos aéreos no tripulados utilizando inteligencia artificial (IA) e imágenes de satélite para reproducir escenarios del mundo real.

YOLO v4 (Sólo se mira una vez, versión 4)

Un algoritmo de detección de objetos de última generación que utiliza redes neuronales convolucionales (CNN) para identificar y localizar rápidamente objetos en una imagen, como edificios y árboles.

Conjunto de datos DOTA

Conjunto de datos de imágenes aéreas utilizado para entrenar a YOLO v4 en la identificación de objetos en imágenes de satélite, mejorando su rendimiento en entornos de prueba de UAV.

Máscara R-CNN

Un modelo avanzado de aprendizaje profundo que realiza la segmentación a nivel de píxel, identificando y delineando áreas específicas dentro de una imagen, como carreteras y formas complejas.

Conjunto de datos del reto de detección de redes viarias de Spacenet

Conjunto de datos utilizado para entrenar el modelo Mask R-CNN para la detección de carreteras en imágenes de satélite, ayudando a crear entornos de simulación más detallados.

Redes neuronales convolucionales (CNN)

Clase de algoritmos de aprendizaje profundo utilizados para analizar imágenes visuales. YOLO v4 y Mask R-CNN utilizan CNN para la detección y segmentación de objetos.

Simulador Gazebo 3D

Herramienta de simulación robótica que representa entornos físicos en 3D, lo que permite probar y desarrollar vehículos aéreos no tripulados en entornos realistas.

ROS (Sistema operativo para robots)

Plataforma de código abierto que proporciona el marco para controlar robots, incluidos vehículos aéreos no tripulados, permitiéndoles funcionar de forma autónoma o ser controlados manualmente.

Resumen de 3 minutos

¿No tiene tiempo ahora de leer el artículo completo? Obtenga los puntos clave del mismo en este resumen de tres minutos.

A medida que los drones y sus aplicaciones ganan terreno en sectores como la seguridad, el transporte y la logística, las pruebas con UAV cobran cada vez más importancia. Sin embargo, las pruebas de estos drones suelen consistir en costosas demostraciones en el mundo real o en simulaciones 3D genéricas y limitadas que no reproducen con exactitud los entornos del mundo real. El artículo, Autonomous Environment Generator for UAV-Based Simulation, presenta una solución innovadora: un sistema autónomo que genera entornos de prueba realistas para UAV basados en imágenes de satélite del mundo real.

Utilizando algoritmos de aprendizaje automático como YOLO v4 y Mask R-CNN, el sistema puede detectar objetos como edificios, árboles y carreteras en imágenes de satélite y, a continuación, colocar modelos 3D de estos objetos en una simulación. El simulador Gazebo se utiliza para renderizar estos entornos, que luego pueden ser recorridos por drones controlados mediante el Sistema Operativo de Robots (ROS).

La principal ventaja de esta plataforma es su capacidad para reproducir entornos reales en un entorno virtual, lo que hace que las pruebas con UAV sean más realistas, accesibles y escalables. Las plataformas actuales carecen de precisión en el mundo real o requieren la colocación manual de objetos 3D, pero este sistema automatiza el proceso, lo que reduce significativamente el tiempo y el coste de las pruebas.

A pesar de su éxito, hay aspectos que mejorar, como la necesidad de modelos de objetos más detallados y tiempos de carga más rápidos. En el futuro, la plataforma pretende incluir la posibilidad de guardar y recargar simulaciones, lo que la haría aún más flexible para pruebas repetidas.

Respuestas a sus preguntas

Una rápida sesión de preguntas y respuestas en la que se profundiza en las tecnologías de vanguardia que hay detrás de las pruebas con vehículos aéreos no tripulados, desde la generación de entornos autónomos hasta el aprendizaje automático y las simulaciones por satélite.