- Les essais de drones sont de plus en plus importants. Cependant, les essais de drones impliquent souvent soit des démonstrations coûteuses dans le monde réel, soit des simulations génériques limitées en 3D.

- Le principal avantage de cette plateforme est sa capacité à reproduire des environnements réels dans un cadre virtuel, ce qui rend les essais de drones plus réalistes, plus accessibles et plus évolutifs.

- Deux algorithmes d'apprentissage profond, YOLO v4 et Mask R-CNN, sont utilisés pour créer l'environnement de simulation 3D.

Index

Besoin actuel d'environnements de simulation réalistes

Avec le développement rapide de la technologie et des applications des drones au cours des dernières années, la demande de véhicules aériens sans pilote (UAV) a augmenté de façon exponentielle. Par conséquent, les fabricants de drones ont de plus en plus recours à des environnements simulés pour tester leurs produits en raison de leur rentabilité et de leur sécurité par rapport aux essais en conditions réelles. Cependant, les environnements simulés génériques et créés manuellement ne parviennent souvent pas à présenter les défis rencontrés dans les scénarios du monde réel.

Alors, comment résoudre ce problème pour que les environnements simulés reflètent plus fidèlement les conditions réelles ? C'est le défi auquel se sont attaqués les chercheurs Justin Nakama, Ricky Parada, João P. Matos-Carvalho, Fábio Azevedo, Dário Pedro et Luís Campos. Leurs efforts ont abouti à la mise au point d'une nouvelle approche fondée sur des algorithmes d'apprentissage automatique.

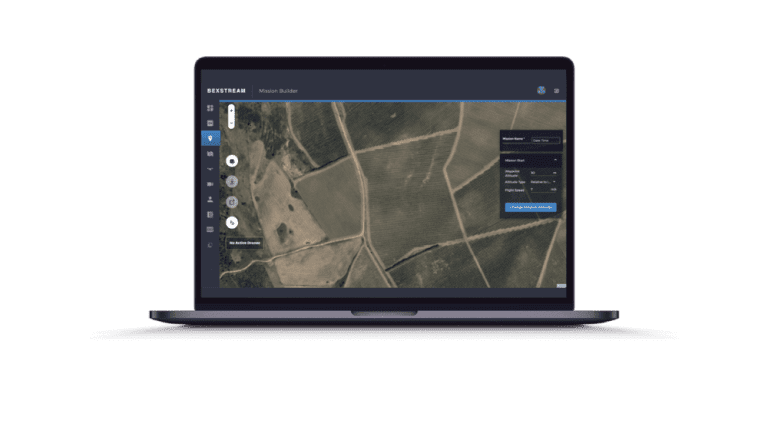

Dans leur article intitulé Autonomous Environment Generator for UAV-Based Simulation, ils proposent un nouveau banc d'essai dans lequel l'apprentissage automatique est utilisé pour générer, mettre à l'échelle et placer des modèles 3D de manière procédurale, ce qui permet d'obtenir des simulations de plus en plus réalistes. Les images satellites servent de base à ces environnements, ce qui permet aux utilisateurs de tester les drones dans une représentation plus détaillée des scénarios du monde réel.

Bien que certaines améliorations soient encore nécessaires, leur travail constitue une preuve de concept prometteuse pour un générateur d'environnement qui peut faire gagner du temps et des ressources lors des phases de planification en fournissant des environnements virtuels réalistes pour les essais.

Poursuivez votre lecture pour en savoir plus sur la technologie qui sous-tend ce banc d'essai révolutionnaire et sur ses applications pratiques.

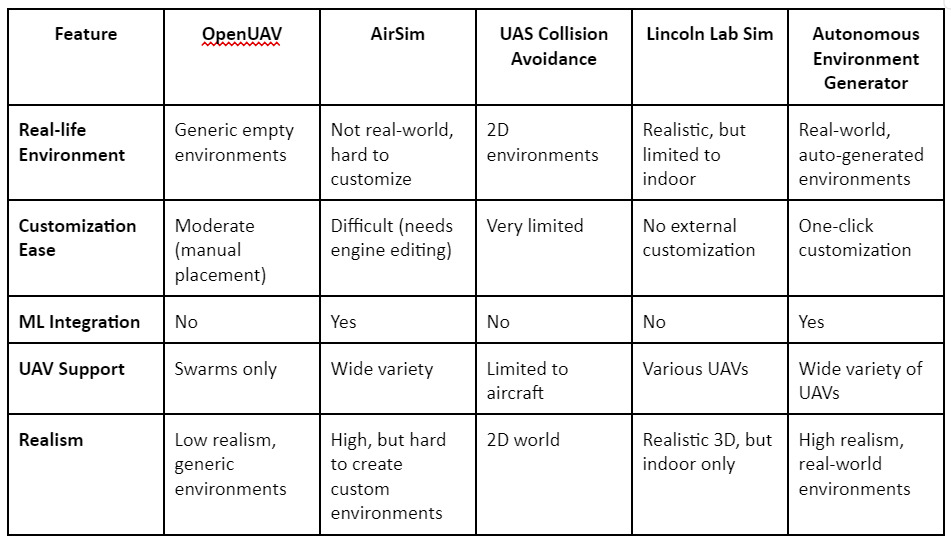

Comparaison : Comparaison des simulateurs existants

Plusieurs plateformes de bancs d'essai de drones existent déjà, comme OpenUAV, AirSim et le simulateur de drones du Lincoln Lab. Bien que ces plateformes offrent des fonctionnalités telles que les tests d'essaims de drones ou un rendu de haute qualité, elles sont toutes insuffisantes lorsqu'il s'agit de la génération automatique d'environnements réalistes. Nombre d'entre elles nécessitent le placement manuel de modèles 3D et n'offrent pas la flexibilité nécessaire pour simuler des emplacements géographiques réels. La plateforme proposée dans cet article comble ces lacunes en automatisant l'ensemble du processus à l'aide d'images satellite, générant ainsi des environnements précis à la demande.

Architecture des systèmes et utilisation d'algorithmes d'IA

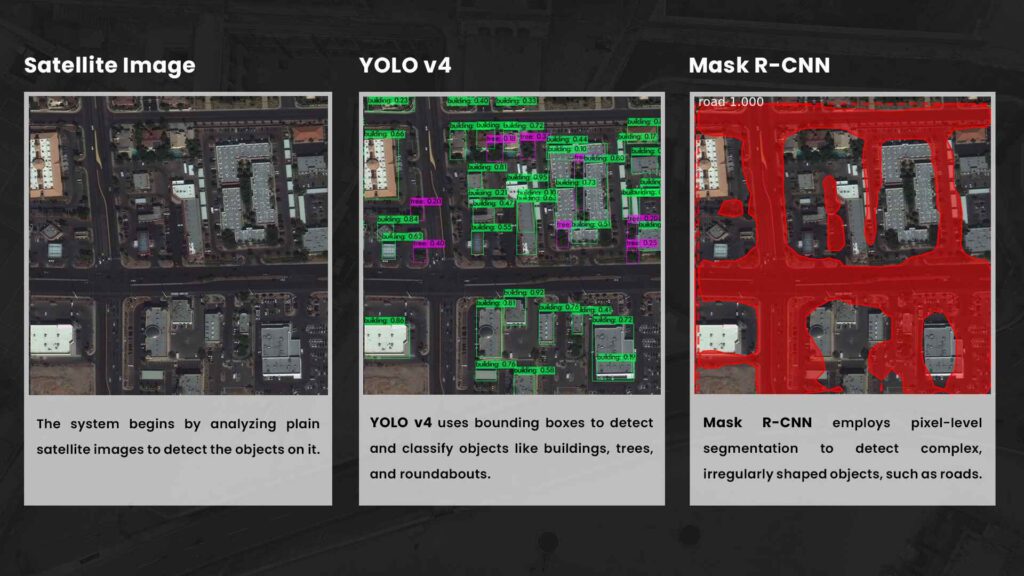

Au cœur du générateur d'environnement autonome se trouve une architecture qui permet la représentation réelle de n'importe quelle zone géographique. Le générateur part d'images satellites, qui sont traitées à l'aide d'algorithmes d'intelligence artificielle pour détecter et reproduire des objets tels que des bâtiments, des arbres et des routes. Ces objets détectés sont ensuite placés dans la simulation à l'aide du simulateur robotique Gazebo 3D, ce qui garantit que l'environnement reflète fidèlement le monde réel.

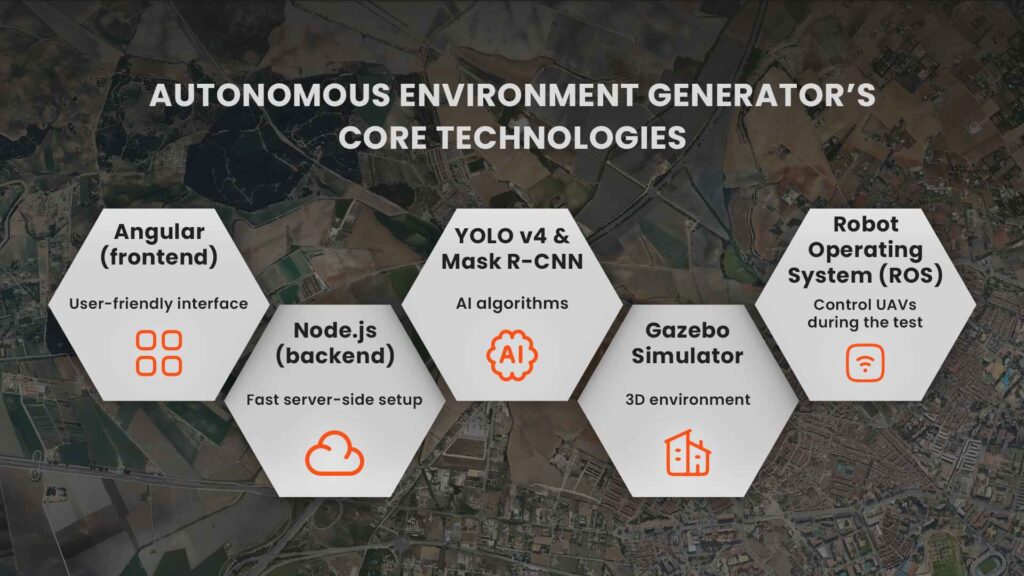

Technologies clés du générateur d'environnement autonome

L'architecture du système est composée de

L'apprentissage automatique est le moteur de la capacité de cette plateforme à créer des environnements dynamiques et réels. Deux algorithmes d'intelligence artificielle, YOLO v4 et Mask R-CNN, sont utilisés pour créer l'environnement de simulation en 3D.

YOLO v4 est un modèle de détection d'objets de pointe qui utilise des réseaux neuronaux convolutionnels pour identifier et localiser des objets dans des images. Il divise les images en une grille et prédit l'emplacement des objets à l'aide de boîtes de délimitation pour chaque région, ce qui permet une détection rapide et précise. Plus précisément, YOLO v4 a été entraîné sur l'ensemble de données DOTA, qui se compose d'images aériennes et satellitaires, ce qui lui permet de se spécialiser dans la détection d'objets tels que les bâtiments, les arbres et les ronds-points à partir d'une vue d'oiseau.

Masque R-CNNEn revanche, il est utilisé pour la détection des routes, qui nécessite une segmentation au niveau du pixel. Il génère des masques qui offrent plus de précision pour les formes complexes qui ne s'intègrent pas parfaitement dans une boîte de délimitation. Ce modèle a été entraîné à l'aide de l'ensemble de données Spacenet Road Network Detection Challenge.

Alors que YOLO v4 est excellent pour détecter certains objets, sa détection des routes est moins précise, c'est pourquoi Mask R-CNN est incorporé dans l'architecture pour une segmentation plus détaillée.

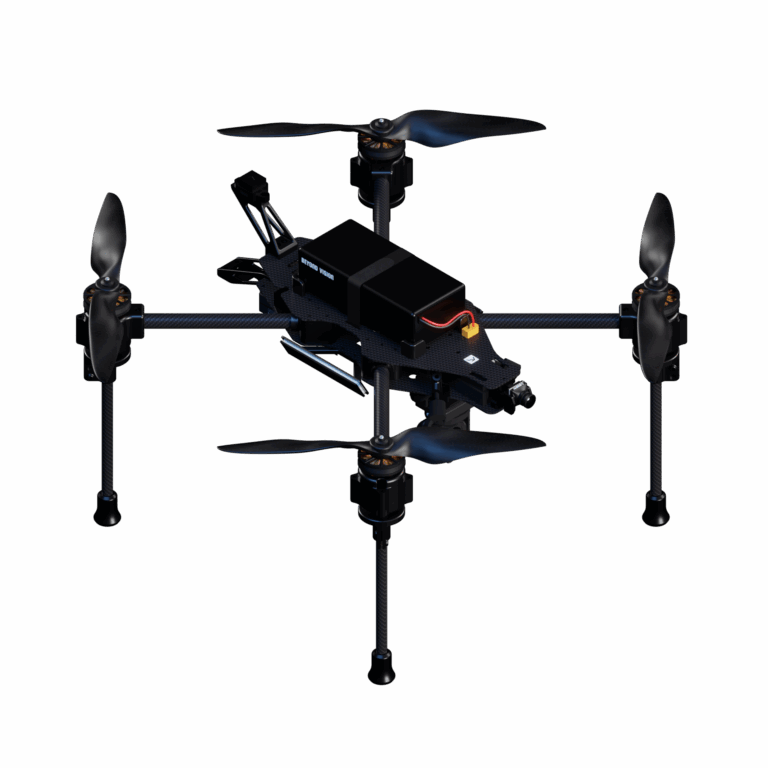

Heifu : le drone utilisé dans les simulations

Le générateur a été formé sur des ensembles de données d'images aériennes et atteint un équilibre entre vitesse et précision. Une fois les images satellite traitées et les objets détectés, les données sont envoyées au backend, où elles sont stockées en vue d'une utilisation ultérieure. Les modèles 3D de bâtiments, d'arbres et d'autres objets sont ensuite mis à l'échelle et placés dans le simulateur Gazebo à leur position géographique correcte. La simulation est contrôlée à l'aide du Robot Operating System (ROS), qui permet aux utilisateurs de contrôler manuellement ou de manière autonome les drones pendant le test. Les drones interagissent avec ces modèles, ce qui permet aux testeurs de simuler des scénarios de vol réels, tels que la navigation dans un environnement urbain.

Les deux modèles ont été testés sur une variété d'images satellites et ont donné de bons résultats dans l'ensemble. Toutefois, certains défis subsistent, notamment en ce qui concerne le placement de géométries de bâtiments complexes.

Alors que YOLO v4 est excellent pour détecter certains objets, sa détection des routes est moins précise, c'est pourquoi Mask R-CNN est incorporé dans l'architecture pour une segmentation plus détaillée.

Bien que le système actuel manque de détails graphiques avancés, la force de la plateforme réside dans son évolutivité et son réalisme. Elle élimine le besoin d'environnements d'essai physiques, ce qui rend les essais de drones moins chers, plus rapides et plus accessibles.

Prochaines étapes Améliorations du générateur d'environnement autonome

Bien que le générateur d'environnement autonome soit déjà un outil puissant, les auteurs soulignent certains domaines susceptibles d'être améliorés à l'avenir :

Ces améliorations rendront la plateforme encore plus polyvalente et capable de gérer des scénarios d'essais de drones plus complexes à l'avenir.

Un générateur d'environnement autonome représente un avenir prometteur pour les essais de drones et constitue un système qui révolutionnera la manière dont les fabricants de drones testent et garantissent les performances de leurs produits.

Générateur d'environnement autonome

Proposition d'un système qui crée automatiquement des environnements 3D pour les essais de drones en utilisant l'intelligence artificielle (IA) et l'imagerie satellite pour reproduire des scénarios du monde réel.

YOLO v4 (You Only Look Once, Version 4)

Un algorithme de détection d'objets à la pointe de la technologie utilisant des réseaux neuronaux convolutionnels (CNN) pour identifier et localiser rapidement des objets dans une image, tels que des bâtiments et des arbres.

Ensemble de données DOTA

Un ensemble de données d'imagerie aérienne utilisé pour entraîner YOLO v4 à l'identification d'objets dans des images satellite, améliorant ainsi ses performances dans des environnements de test de drones.

Masque R-CNN

Un modèle d'apprentissage profond avancé qui effectue une segmentation au niveau des pixels, en identifiant et en soulignant des zones spécifiques dans une image, telles que les routes et les formes complexes.

Jeu de données Spacenet pour la détection des réseaux routiers

Ensemble de données utilisé pour entraîner le modèle R-CNN de Mask à la détection des routes dans les images satellite, ce qui permet de créer des environnements de simulation plus détaillés.

Réseaux neuronaux convolutifs (CNN)

Classe d'algorithmes d'apprentissage profond utilisés pour analyser l'imagerie visuelle. YOLO v4 et Mask R-CNN s'appuient tous deux sur des CNN pour la détection et la segmentation d'objets.

Gazebo 3D Simulator

Un outil de simulation robotique qui restitue des environnements physiques en 3D, permettant de tester et de développer des drones dans des environnements réalistes.

ROS (Robot Operating System)

Une plateforme open-source qui fournit le cadre de contrôle des robots, y compris les drones, leur permettant de fonctionner de manière autonome ou d'être contrôlés manuellement.

Résumé en 3 minutes

Vous n'avez pas le temps de lire l'article en entier ? Retrouvez les points essentiels dans ce résumé de trois minutes.

À mesure que les drones et leurs applications gagnent en importance dans des secteurs tels que la sécurité, le transport et la logistique, les essais de drones deviennent de plus en plus importants. Cependant, les tests de ces drones impliquent souvent des démonstrations coûteuses dans le monde réel ou des simulations génériques limitées en 3D qui ne reproduisent pas fidèlement les environnements du monde réel. L'article intitulé "Autonomous Environment Generator for UAV-Based Simulation" présente une solution révolutionnaire : un système autonome qui génère des environnements d'essai réalistes pour les drones sur la base d'images satellites du monde réel.

En utilisant des algorithmes d'apprentissage automatique tels que YOLO v4 et Mask R-CNN, le système peut détecter des objets tels que des bâtiments, des arbres et des routes dans des images satellites, puis placer des modèles 3D de ces objets dans une simulation. Le simulateur Gazebo est utilisé pour rendre ces environnements, qui peuvent ensuite être parcourus par des drones contrôlés par le système d'exploitation des robots (ROS).

Le principal avantage de cette plateforme est sa capacité à reproduire des environnements réels dans un cadre virtuel, ce qui rend les essais de drones plus réalistes, plus accessibles et plus évolutifs. Les plateformes actuelles manquent de précision dans le monde réel ou nécessitent le placement manuel d'objets en 3D, mais ce système automatise le processus, ce qui réduit considérablement le temps et le coût des essais.

Malgré son succès, il reste des points à améliorer, comme la nécessité d'avoir des modèles d'objets plus détaillés et des temps de chargement plus rapides. À l'avenir, la plateforme vise à inclure la possibilité de sauvegarder et de recharger les simulations, ce qui la rendra encore plus flexible pour des essais répétés.

Réponses à vos questions

Une séance rapide de questions-réponses sur les technologies de pointe qui sous-tendent les essais de drones, de la génération d'environnements autonomes à l'apprentissage automatique et aux simulations basées sur les satellites.