- Drohnentests gewinnen zunehmend an Bedeutung. Bei Drohnentests werden jedoch häufig entweder teure reale Demonstrationen oder begrenzte, allgemeine 3D-Simulationen durchgeführt.

- Der Hauptvorteil dieser Plattform ist die Fähigkeit, reale Umgebungen in einer virtuellen Umgebung nachzubilden, was Drohnentests realistischer, zugänglicher und skalierbarer macht.

- Zwei Deep-Learning-Algorithmen, YOLO v4 und Mask R-CNN, werden zur Erstellung der 3D-Simulationsumgebung verwendet.

Index

Aktueller Bedarf an realistischen Simulationsumgebungen

Mit der rasanten Entwicklung der Drohnentechnologie und -anwendungen in den letzten Jahren ist die Nachfrage nach unbemannten Luftfahrzeugen (Unmanned Aerial Vehicles, UAVs) exponentiell angestiegen. Infolgedessen haben sich die Drohnenhersteller zunehmend auf simulierte Umgebungen für Produkttests verlassen, da diese im Vergleich zu realen Tests kostengünstiger und sicherer sind. Allerdings können generische und manuell erstellte simulierte Umgebungen oft nicht die Herausforderungen darstellen, die in realen Szenarien auftreten.

Wie können wir also dieses Problem angehen, um sicherzustellen, dass simulierte Umgebungen die realen Bedingungen besser widerspiegeln? Dieser Herausforderung haben sich die Forscher Justin Nakama, Ricky Parada, João P. Matos-Carvalho, Fábio Azevedo, Dário Pedro und Luís Campos gestellt. Ihre Bemühungen führten zur Entwicklung eines neuen Ansatzes, der auf Algorithmen des maschinellen Lernens beruht.

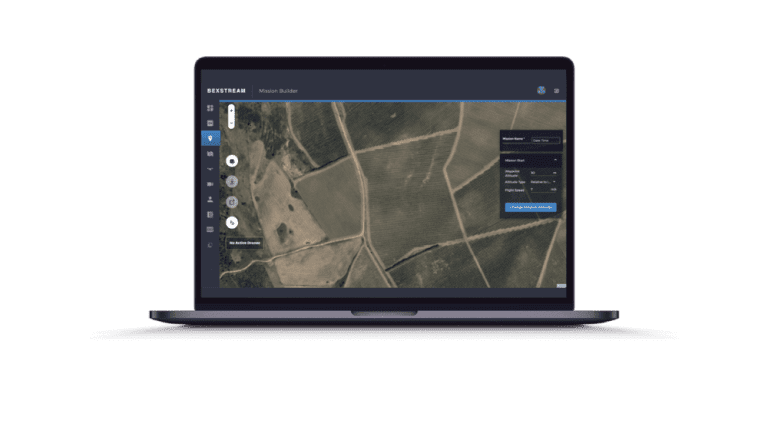

In ihrem Beitrag Autonomous Environment Generator for UAV-Based Simulation (Autonomer Umgebungsgenerator für UAV-basierte Simulation) schlagen sie eine neuartige Testumgebung vor, in der maschinelles Lernen zur prozeduralen Erzeugung, Skalierung und Platzierung von 3D-Modellen eingesetzt wird, was zu immer realistischeren Simulationen führt. Satellitenbilder dienen als Grundlage für diese Umgebungen und ermöglichen es den Benutzern, UAVs in einer detaillierteren Darstellung realer Szenarien zu testen.

Obwohl noch einige Verbesserungen erforderlich sind, stellt ihre Arbeit einen vielversprechenden Konzeptnachweis für einen Umgebungsgenerator dar, der in der Planungsphase Zeit und Ressourcen sparen kann, indem er realistische virtuelle Umgebungen für Tests bereitstellt.

Lesen Sie weiter und erfahren Sie mehr über die Technologie, die hinter dieser bahnbrechenden Testumgebung steckt, und ihre praktischen Anwendungen.

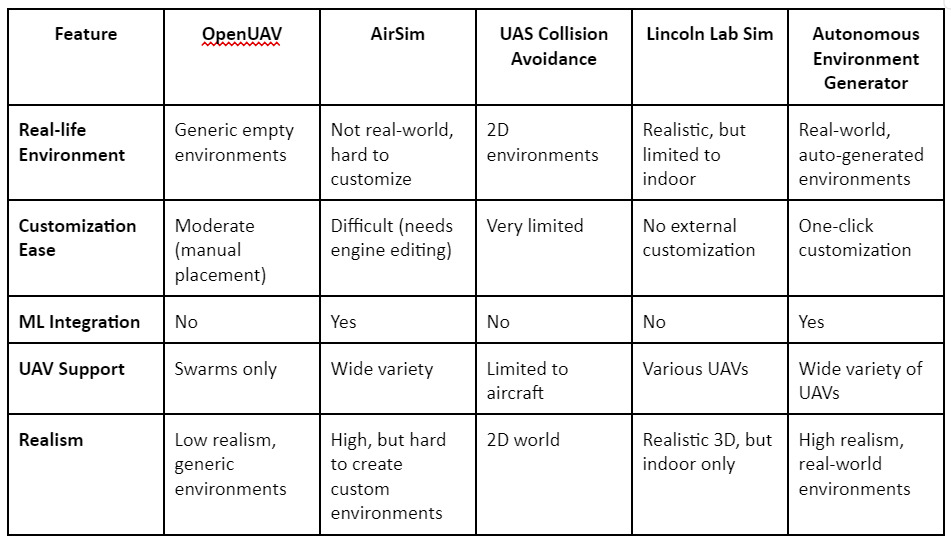

Vergleich: Wie bestehende Simulatoren abschneiden

Es gibt bereits mehrere UAV-Testplattformen wie OpenUAV, AirSim und den Lincoln Lab UAV Simulator. Diese Plattformen bieten zwar Funktionen wie UAV-Schwarmtests oder hochwertiges Rendering, aber sie sind alle unzureichend, wenn es um die automatische Erzeugung realistischer Umgebungen geht. Viele erfordern die manuelle Platzierung von 3D-Modellen und bieten nicht die Flexibilität, tatsächliche geografische Standorte zu simulieren. Die in diesem Beitrag vorgeschlagene Plattform schließt diese Lücken, indem sie den gesamten Prozess auf der Grundlage von Satellitenbildern automatisiert und so bei Bedarf präzise Umgebungen erzeugt.

Systemarchitektur und der Einsatz von KI-Algorithmen

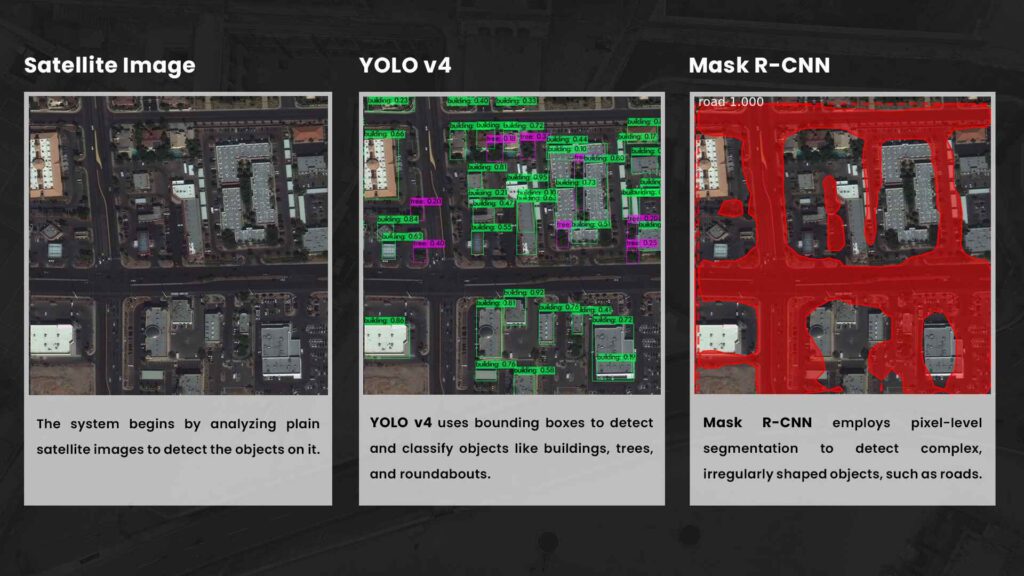

Das Herzstück des Autonomous Environment Generator ist eine Architektur, die es ermöglicht, jedes beliebige geografische Gebiet realitätsnah darzustellen. Ausgangspunkt sind Satellitenbilder, die mithilfe von KI-Algorithmen verarbeitet werden, um Objekte wie Gebäude, Bäume und Straßen zu erkennen und nachzubilden. Diese erkannten Objekte werden dann mit Hilfe des Gazebo 3D-Robotiksimulators in der Simulation platziert, wodurch sichergestellt wird, dass die Umgebung die reale Welt genau widerspiegelt.

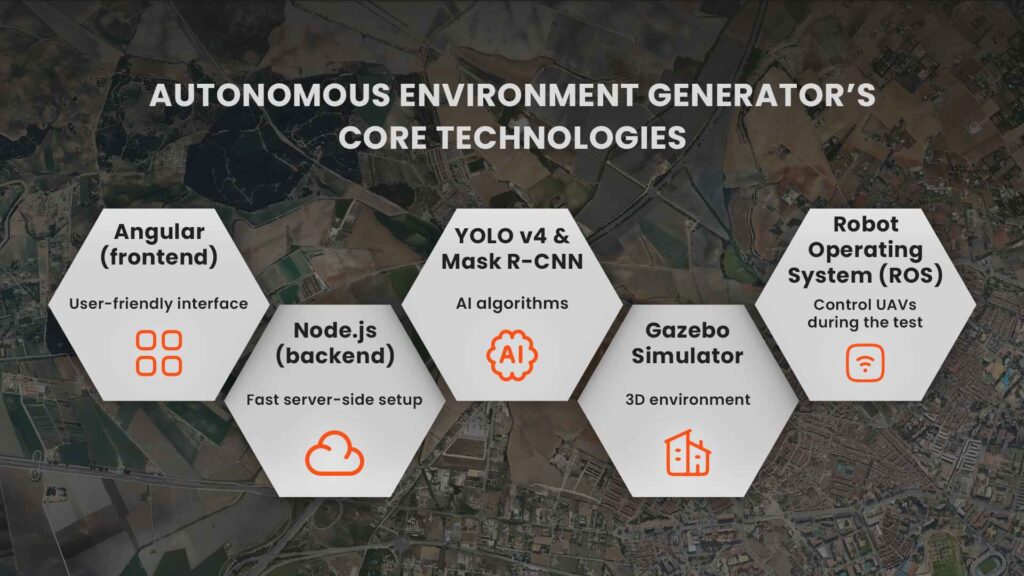

Schlüsseltechnologien für den Generator für autonome Umgebungen

Die Systemarchitektur setzt sich zusammen aus:

Maschinelles Lernen ist die treibende Kraft hinter der Fähigkeit dieser Plattform, dynamische, realitätsnahe Umgebungen zu schaffen. Zwei Algorithmen der künstlichen Intelligenz, YOLO v4 und Mask R-CNN, werden zur Erstellung der 3D-Simulationsumgebung verwendet.

YOLO v4 ist ein hochmodernes Objekterkennungsmodell, das neuronale Faltungsnetzwerke verwendet, um Objekte in Bildern zu erkennen und zu lokalisieren. Es unterteilt Bilder in ein Raster und sagt die Position von Objekten mithilfe von Begrenzungsrahmen für jede Region voraus, was eine schnelle und genaue Erkennung ermöglicht. YOLO v4 wurde speziell auf dem DOTA-Datensatz trainiert, der aus Luft- und Satellitenbildern besteht, und ist daher auf die Erkennung von Objekten wie Gebäuden, Bäumen und Kreisverkehren aus der Vogelperspektive spezialisiert.

Maske R-CNNwird dagegen für die Straßenerkennung verwendet, die eine Segmentierung auf Pixelebene erfordert. Es erzeugt Masken, die eine höhere Präzision für komplexe Formen bieten, die nicht genau in eine Bounding Box passen. Dieses Modell wurde anhand des Spacenet Road Network Detection Challenge-Datensatzes trainiert.

YOLO v4 eignet sich zwar hervorragend für die Erkennung bestimmter Objekte, die Straßenerkennung ist jedoch weniger genau, weshalb Mask R-CNN in die Architektur integriert wurde, um eine detailliertere Segmentierung zu ermöglichen.

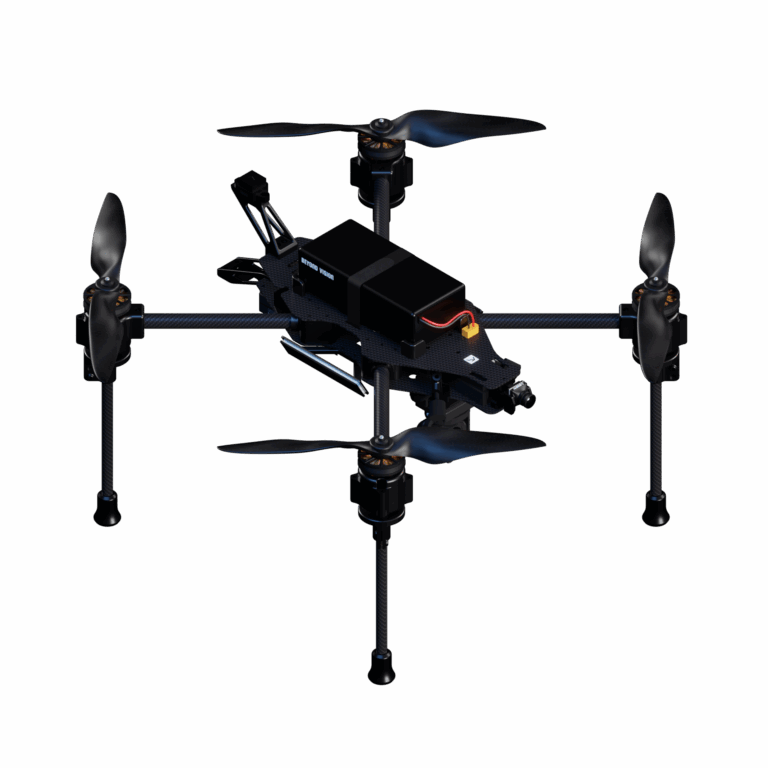

Heifu: die in Simulationen verwendete Drohne

Der Generator wurde auf Luftbilddatensätzen trainiert und erreicht ein ausgewogenes Verhältnis zwischen Geschwindigkeit und Genauigkeit. Nach der Verarbeitung der Satellitenbilder und der Erkennung von Objekten werden die Daten an das Backend gesendet, wo sie zur späteren Verwendung gespeichert werden. Die 3D-Modelle von Gebäuden, Bäumen und anderen Objekten werden dann skaliert und im Gazebo-Simulator an ihren korrekten geografischen Positionen platziert. Die Simulation wird mit dem Robot Operating System (ROS) gesteuert, mit dem die Benutzer die Drohnen während des Tests manuell oder autonom steuern können. Die Drohnen interagieren mit diesen Modellen und ermöglichen es den Testern, reale Flugszenarien zu simulieren, z. B. das Navigieren durch eine städtische Umgebung.

Beide Modelle wurden an einer Vielzahl von Satellitenbildern getestet und schnitten insgesamt gut ab. Allerdings gibt es noch einige Herausforderungen, insbesondere bei der Platzierung komplexer Gebäudegeometrien.

YOLO v4 eignet sich zwar hervorragend für die Erkennung bestimmter Objekte, die Straßenerkennung ist jedoch weniger genau, weshalb Mask R-CNN in die Architektur integriert wurde, um eine detailliertere Segmentierung zu ermöglichen.

Obwohl dem aktuellen System einige fortschrittliche grafische Details fehlen, liegt die Stärke der Plattform in ihrer Skalierbarkeit und Realitätsnähe. Sie macht physische Testumgebungen überflüssig und macht UAV-Tests billiger, schneller und leichter zugänglich.

Was kommt als Nächstes? Verbesserungen am Generator für autonome Umgebungen

Obwohl der Autonomous Environment Generator bereits ein leistungsfähiges Werkzeug ist, skizzieren die Autoren einige Bereiche für zukünftige Verbesserungen:

Durch diese Verbesserungen wird die Plattform noch vielseitiger und kann in Zukunft noch komplexere UAV-Testszenarien bewältigen.

Ein autonomer Umgebungsgenerator stellt eine vielversprechende Zukunft für das Testen von UAVs dar und ist ein System, das die Art und Weise revolutionieren wird, wie Drohnenhersteller die Leistung ihrer Produkte testen und sicherstellen.

Autonomer Umweltgenerator

Ein vorgeschlagenes System, das mit Hilfe von künstlicher Intelligenz (KI) und Satellitenbildern automatisch 3D-Umgebungen für UAV-Tests erstellt, um reale Szenarien nachzubilden.

YOLO v4 (You Only Look Once, Version 4)

Ein hochmoderner Algorithmus zur Objekterkennung, der Faltungsneuronale Netze (CNNs) verwendet, um Objekte in einem Bild, wie z. B. Gebäude und Bäume, schnell zu identifizieren und zu lokalisieren.

DOTA-Datensatz

Ein Datensatz von Luftbildern, der zum Training von YOLO v4 bei der Identifizierung von Objekten in Satellitenbildern verwendet wird, um seine Leistung in UAV-Testumgebungen zu verbessern.

Maske R-CNN

Ein fortschrittliches Deep-Learning-Modell, das eine Segmentierung auf Pixelebene durchführt und dabei bestimmte Bereiche innerhalb eines Bildes, wie z. B. Straßen und komplexe Formen, identifiziert und hervorhebt.

Spacenet Road Network Detection Challenge Datensatz

Ein Datensatz, der zum Trainieren des Mask R-CNN-Modells für die Erkennung von Straßen in Satellitenbildern verwendet wird und zur Erstellung detaillierterer Simulationsumgebungen beiträgt.

Faltungsneuronale Netze (CNNs)

Eine Klasse von Deep-Learning-Algorithmen für die Analyse visueller Bilder. YOLO v4 und Mask R-CNN basieren beide auf CNNs für die Objekterkennung und -segmentierung.

Gartenlaube 3D Simulator

Ein Robotik-Simulationstool, das physische Umgebungen in 3D darstellt und die Prüfung und Entwicklung von UAVs in realistischen Umgebungen ermöglicht.

ROS (Roboter-Betriebssystem)

Eine Open-Source-Plattform, die den Rahmen für die Steuerung von Robotern, einschließlich UAVs, bietet und es ihnen ermöglicht, autonom zu arbeiten oder manuell gesteuert zu werden.

3-Minuten-Zusammenfassung

Sie haben jetzt keine Zeit, den ganzen Artikel zu lesen? In dieser dreiminütigen Zusammenfassung finden Sie die wichtigsten Punkte des Artikels.

Da Drohnen und ihre Anwendungen in Branchen wie Sicherheit, Transport und Logistik immer mehr an Bedeutung gewinnen, werden Drohnentests immer wichtiger. Die Prüfung dieser Drohnen erfordert jedoch häufig entweder teure Demonstrationen in der realen Welt oder begrenzte, generische 3D-Simulationen, die reale Umgebungen nicht genau nachbilden. Das Papier Autonomous Environment Generator for UAV-Based Simulation stellt eine bahnbrechende Lösung vor: ein autonomes System, das realistische Testumgebungen für UAVs auf der Grundlage realer Satellitenbilder erzeugt.

Durch den Einsatz von Algorithmen des maschinellen Lernens wie YOLO v4 und Mask R-CNN kann das System Objekte wie Gebäude, Bäume und Straßen in Satellitenbildern erkennen und dann 3D-Modelle dieser Objekte in einer Simulation platzieren. Der Gazebo-Simulator wird zum Rendern dieser Umgebungen verwendet, die dann von Drohnen navigiert werden können, die über das Robot Operating System (ROS) gesteuert werden.

Der Hauptvorteil dieser Plattform besteht darin, dass sie reale Umgebungen in einer virtuellen Umgebung nachbilden kann, was Drohnentests realistischer, zugänglicher und skalierbarer macht. Aktuelle Plattformen sind entweder nicht realitätsgetreu oder erfordern die manuelle Platzierung von 3D-Objekten. Dieses System automatisiert den Prozess und reduziert den Zeit- und Kostenaufwand für die Prüfung erheblich.

Trotz des Erfolges gibt es Verbesserungsmöglichkeiten, wie z. B. detailliertere Objektmodelle und schnellere Ladezeiten. In Zukunft soll die Plattform die Möglichkeit bieten, Simulationen zu speichern und neu zu laden, um sie für wiederholte Tests noch flexibler zu machen.

Ihre Fragen beantwortet

Eine schnelle Frage- und Antwortrunde, die sich mit den Spitzentechnologien für UAV-Tests befasst, von der Erzeugung autonomer Umgebungen bis hin zu maschinellem Lernen und satellitengestützten Simulationen.